RAWR

Описание RAWR

Быстрая оценка веб-ресурсов.

Особенности:

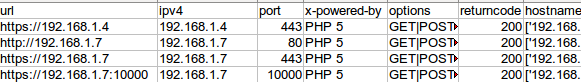

- Настраиваемый CSV, содержащий упорядоченную информацию, собранную для каждого хоста с полем для создания заметок и т.п.

- Элегантный, доступный для поиска, работающий на JQuery отчёт в HTML формате, который показывает скриншоты, диаграммы и другую информацию.

- Отчет о соответствующих заголовках безопасности (используется парсер от SmeegeSec).

- CSV Матрица Угроз для простого обзора открытых портов для всех представленных портов (используйте -a для показа всех портов)

- Словарь для каждого хоста, состоящий из всех слов, найденных в ответах (включая сканирование, если оно использовалось).

- Подбор стандартных паролей через проверку CPE службы на совпадения в базе данных DPE.

- База данных со всей собранный с хоста информацией (запланирована функция сравнения).

- Разбор метаданных в документах и фотографиях с использованием настраиваемых модулей.

- Поддержка использования прокси (Burp, Zap, W3aF)

- Может делать скриншоты RDP и VNC интерфейсов без пароля.

- Будет выполнять множественные веб-вызовы на основе пользовательского списка user-agent (пользовательских агентов).

- Захват/сохранение SSL сертификатов, кукиз и Cross-domain.xml

- [Опционально] Уведомит по почте или SMS когда сканирование завершиться.

- [Опционально] Настраиваемый обходчик (сканер) для сбора ссылок внутри домена хоста.

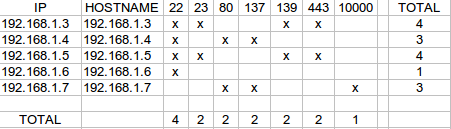

- [Опционально] Диаграмма в PNG всех найденных во время обхода страниц.

- [Опционально] Список собранных ссылок в многоуровневом формате.

- [Опционально] Список увиденных на каждом сайте документов.

- [Опционально] Дружелюбный к автоматизации вывод (JSON строки)

Домашняя страница: https://bitbucket.org/al14s/rawr/wiki/Home

Автор: Adam Byers (al14s)

Лицензия: GPLv3

Справка по RAWR

использование:

./rawr.py <URL|NMap Диапазон|Файл> [опции]

позиционные аргументы:

ввод_цели URL, NMap диапазон, RAWR .cfg файл, список ввода NMap ,

NMap|Metasploit|Nessus|Nexpose|Qualys|OpenVAS XML

отчёт или директории из которых взять эти файлы.

При использовании подстановочных символов

используйте кавычки..

напр.: "*.nessus" разберёт все файлы .nessus

в директории (GLOB).

опциональные аргументы:

-h, --help показать справку и выйти

-a Включить все открытые порты в .csv и Surface Matrix.

-m Входные данные процесса, создать Attack Surface Matrix,

затем выйти.

-p <порт(ы)> Укажите порт(ы) для сканирования.

[по умолчанию это '80,443,8080,8088']

-s <порт> Укажите порт источника для NMap сканирования.

-t (1-5) Установить пользовательский тайминг сканирования NMap. [по умолчанию это 4]

-u Обновить — Проверить на новые версии требуемые файлы.

* Игнорирует другие аргументы.

-v Вербальность — Показывать такие сообщения как обновления статуса паука.

--sslv Оценить безопасность SSL для каждой цели.

[считается навязчивым]

-S (1-5) Использовать пресент уровня агрессивности обходчика.

Уровни перечислены в settings.py.

--spider-opts <опции>

Предоставьте пользовательские настройки для обхода.

s='следовать за субдоменами', d=глубина, l='лимит url'

t='таймаут обходчика', u='таймаут url', th='лимит потоков'

Пример: --spider-opts s:false,d:2,l:500,th:1

ПЕРЕЧИСЛЕНИЕ:

--dns Использовать Bing для обратных DNS преобразований.

-o Сделать вызов 'OPTIONS' для сбора доступных на сайте

методов.

-r Сделать дополнительный веб-вызов для получения "robots.txt"

-x Сделать дополнительный веб-вызов для получения "crossdomain.xml"

--downgrade Делать запросы используя HTTP 1.0

--noss Отключить скриншоты.

--rd Сделать скриншоты RDP и VNC интерфейсов.

--proxy <[имя пользователя:пароль@]ip:порт[+тип] | имя файла>

Отправлять весь трафик через прокси.

Поддерживаемые типы: socks и http,basic, digest.

Файл должен содержать в строке информацию о прокси.

пример - 'username:password@127.0.0.1:9050+socks'

--proxy-auth Укажите аутентификацию для прокси-сервера во время

выполнения с помощью getpass.

--spider Перечислить все url в целевом HTML, создать диаграмму

макета сайта. Запишет, но не будет следовать ссылкам

вне целевого домена. Создаст карту (.png) для этого сайта

в папке <logfolder>/maps.

--udp Делать во время сканирования NMap проверки для TCP и UDP.

--alt-domains <домены>

Включить междоменный поиск в определенных доменах.

(разделять запятыми)

--blacklist-urls <файл>

Чёрный список определённых url во время обхода. Требует

для ввода построчный список.

--mirror Обойти и создать кэшированную копию сайта, сохранённую

в папке 'mirrored_sites'. Примечание: Это инициирует

обход, следовательно опция --spider не нужна.

Любые обычные опции паука можно использовать,

указывая их как показано выше.

--useragent <строка|файл>

Использовать пользовательский user agent. По умолчанию указаны в settings.py.

Принимается разделённые на строки списки useragent.

** Это экспоненциально увеличит количество

интерфейсов! **

ВЫВОД:

-d <папка> Директория, в которой создать папку журнала

[по умолчанию это "./"]

-q, --quiet Не показывать заставку.

-z По окончанию сжать папку логов.

--json stdout (стандартный вывод) будет включать только строки JSON.

Нормально созданные папки журнала и файлы.

--json-min Этот скрипт будет выводить в стандартный вывод

только строки JSON.

--notify [email адрес]

Отправить email или SMS уведомление через sendmail когда

завершится сканирования. Указывать email адрес получателя

необязательно, если он определён в settings.py.

(Требуется настройка в conf/settings.py)

--parsertest Разберёт вывод, отобразит первые 3 и выйдет.

СОСТАВЛЕНИЕ ОТЧЁТОВ:

-e Исключить из вывода данные о стандартном имени пользователя/пароле.

--logo <file> Укажите файл логотипа для HTML отчёта.

--title "Title" Укажите пользовательское название для HTML отчёта.

Руководство по RAWR

Страница man отсутствует.

Ввод

- Использование данных, полученных в предыдущих сканированиях

- rawr.py <файл, csv список файлов, директория>

- Программа понимает следующие форматы:

- NMap - XML (требует -sV)

- PowerSploit - XML вывод сканирования портов

- Nessus - XML v2 (требует плагин "Service Detection")

- Metasploit - CSV

- Qualys - Port Services Report CSV

- Qualys - Asset Search XML (требует QIDs 86000,86001,86002)

- Nexpose - Simple XML, XML, XML v2

- OpenVAS - XML

- Использование NMap

- RAWR принимает валидные строки ввода NMap (CIDR, прочее) в качестве аргумента

- rawr.py <файл> можно использования для скармливания списка, разделённого на строки, содержащего диапазоны NMap или имена хостов.

- используйте -t <timing> и/или -s <исходный порт>

- используйте -p <port|all|fuzzdb> чтобы указать порт #(s), all для 1-65353, или fuzzdb для использования Популярных Портов FuzzDB

- --udp добавит -sU к команде nmap, что означает во время сканирования делать проверку TCP и UDP.

- --ssl вызовет enum-ciphers.nse для более глубоких данных SSL.

- Использование предварительной конфигурации сканирования

- rawr.py <файл RAWR .cfg>

- .cfg файлы содержат настройки сканирования, создаваемые для каждого запуска.

- Любые опции в командной строке переназначат соответствующие настройки в файле .cfg.

- Это позволяет вам запускать одинаковое сканирование без построения команды каждый раз.

Перечисление

- В [conf/settings.py], 'flist' определяет поля, которые будут в CSV, а также отчёт.

- Секция внизу - "DISABLED COLUMNS" представляет собой список интересных аспектов данных, которые не отображаются по умолчанию.

- --rd пытается сделать скриншоты интерфейсов RDP и VNC во время перечисления.

- --dns будет делать запросы в Bing для определения других имён хостов и добавления их в очередь.

- (Планируется) Если IP немаршрутизируемый, RAWR будет делать AXFR запрос используя 'dig'

- Это для внешних ресурсов — немаршрутизируемые пропускаются.

- Результаты хешируется на время сканирования для предотвращения ненужных запросов.

- -o, -r, и -x делают дополнительные запросы для сбора, соответственно, HTTP ОПЦИЙ, robots.txt, и crossdomain.xml

- Попробуйте --downgrade для осуществления запросов с HTTP/1.0

- Возможно получить больше информации от 'болтливой' версии

- Скриншоты всё равно делаются через HTTP/1.1

- --noss пропустит сбор скриншотов

- Отчёт HTML всё равно функционален, но будет показывать изображение '!' для всех хостов.

- Прокси используются с --proxy=<[имя пользователя:пароль@]ip:порт[+тип] | файл>.

- Типы: socks, http, basic и digest.

- Файл должен содержать информацию о прокси в виде [имя пользователя:пароль@]ip:порт[+тип]

- Добавьте --proxy-auth чтобы при запуске RAWR запрашивал учётные данные.

- Пример - username:password@127.0.0.1:8080+http

- Это хорошо работает с BurpSuite, Zap или W3aF.

- Обход (сканирование) сайта опцией --spider, стоящие внимания файлы и документы в директории журнала 'maps'.

- По умолчанию: [conf/settings.py] следовать субдоменам, 3 ссылки в глубину, таймаут на 3 минуты, ограничение на 300 url

- Если установлены graphviz и python-graphviz, то сгенерирует PNG диаграмму каждого просканированного сайта.

- Начните с малого и действуйте в соответствии с обстоятельствами. Будьте осторожны для избежания проблем.

- Используйте -S <1-5> для применения одного из пресетов (предварительного набора настроек) интенсивности сканирования. По умолчанию это 3.

- --mirror то же самое, что и --spider, но во время сканирования также сделает копию каждого сайта.

- Используйте --spider-opts <opts> для установки опций настройки на лету.

- 's' = 'следовать субдоменам', 'd' = глубина, 't' = таймаут, 'l' = лимит url

- Требуются не все, также порядок следования безразличен

- Пример: --spider-opts s:false,d:2,l:500

- Также для обхода, --alt-domains <домены> добавит домены в белый список, по которому вы хотите следовать во время обхода.

- По умолчанию, не будет покинут исходный домен.

- Пример: --alt-domains domain1.com,domain2.com,domain3.com

- --blacklist-urls <список ввода> добавит домены, которые вы не хотите сканировать, в чёрный список.

- --useragent <строка|файл> устанавливает пользовательский user-agent.

- Берёт из указанной строки или делает веб-запросы или делает веб-вызовы с каждым указанным пользовательским агентом из списка.

- Стандартные настройки определены в settings.py.

- Предупреждение: Это приведет к экспоненциальному увеличению количества веб-вызовов и возвращенных интерфейсов!

Вывод

- -a используется для включения всех открытых портов в CSV вывод и Матрицу Угроз.

- -m создаст Матрицу Угроз из предоставленного ввода и выйдет (без веб-вызовов, офлайн режим).

- -d <папка> меняет расположение папки логов со стандартной "./"

- Пример: -d ./Desktop/RAWR_scans_20140227 создаст эту папку и использует её в качестве директории журнала.

- -q или --quiet отключает показ динозавра при запуске.

- Сжатие папки журнала после завершения сканирования опцией -z.

- --json и --json-min являются удобными дли применении вывода RAWR в автоматизации.

- --json в STDOUT (стандартном выводе) показывает только строки JSON но при этом создаются все обычные файлы журналов.

- --json-min без создания файлов вывода, только JSON строки в STDOUT

- Используйте --notify [email адрес] для отправки email или SMS уведомления через sendmail когда сканирование завершено. (Требуется настройка в conf/settings.py)

- Используйте --parsertest если вы тестируйте пользовательский парсер. Опция разбирает ввода, отображает первые три строки и выходит.

- -v делает вывод вербальным.

Настройка отчёта

- -e исключить 'Подбор стандартных паролей' из вывода.

- Дайте вашему HTML отчёту пользовательский логотип и название в --logo=<файл> и --title=<название>.

- Изображение будет скопировано в папку отчёта.

- Кликните 'printable' в HTML отчёте для просмотра пользовательского заголовка.

Обновление

- -u запускает обновление и запросы обновиться, если имеется более актуальная версия файла.

- Загружаются файлы defpass.csv и Ip2Country.tar.gz.

- Проверяет phantomJS и загружает после запроса.

- -U запускает обновление и загружает упомянутые выше файлы независимо от их версии и без запросов.

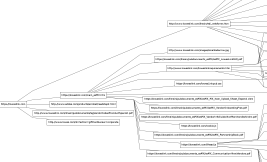

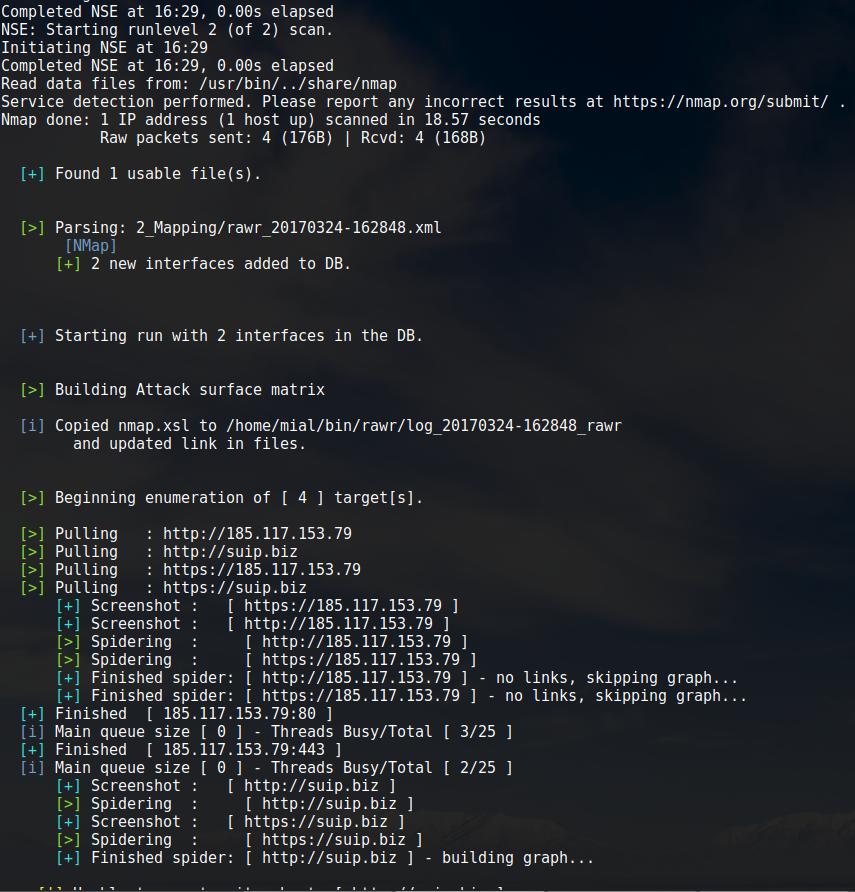

Примеры запуска RAWR

Провести оценку хоста suip.biz, включая оценку SSL (--sslv), загружить файл robots.txt (-r) перечислить все url в целевом HTML, создать диаграмму макета сайта (--spider):

sudo ./rawr.py suip.biz --sslv -r --spider

Установка RAWR

Установка в Kali Linux

git clone https://bitbucket.org/al14s/rawr.git cd rawr sudo ./install.sh

Установка в BlackArch

Программа предустановлена в BlackArch.

Информация об установке в другие операционные системы будет добавлена позже.

Скриншоты RAWR

Инструкции по RAWR

Ссылки на инструкции будут добавлены позже.

Comments are Closed